La legge sull'IA è il primo quadro giuridico in assoluto in materia di IA, che affronta i rischi dell'IA e posiziona l'Europa a svolgere un ruolo guida a livello mondiale.

Il regolamento sull'IA (regolamento (UE) 2024/1689 che stabilisce norme armonizzate sull'intelligenza artificiale) è il primo quadro giuridico completo in assoluto sull'IA a livello mondiale. L'obiettivo delle norme è promuovere un'IA affidabile in Europa.

La legge sull'IA stabilisce una serie chiara di norme basate sul rischio per gli sviluppatori e i deployer di IA per quanto riguarda gli usi specifici dell'IA. La legge sull'IA fa parte di un più ampio pacchetto di misure politiche a sostegno dello sviluppo di un'IA affidabile, che comprende anche il pacchetto sull'innovazione in materia di IA, il lancio delle fabbriche di IA e il piano coordinato sull'IA. Insieme, queste misure garantiscono la sicurezza, i diritti fondamentali e l'IA antropocentrica e rafforzano la diffusione, gli investimenti e l'innovazione nell'IA in tutta l'UE.

Per agevolare la transizione verso il nuovo quadro normativo, la Commissione ha varato il patto per l'IA, un'iniziativa volontaria che mira a sostenere la futura attuazione, dialogare con i portatori di interessi e invitare i fornitori e gli operatori di IA provenienti dall'Europa e dal resto del mondo a rispettare in anticipo gli obblighi fondamentali della legge sull'IA.

Perché abbiamo bisogno di regole sull'IA?

La legge sull'IA garantisce che gli europei possano fidarsi di ciò che l'IA ha da offrire. Sebbene la maggior parte dei sistemi di IA non presenti rischi e possa contribuire a risolvere molte sfide per la società, alcuni sistemi di IA creano rischi che dobbiamo affrontare per evitare risultati indesiderati.

Ad esempio, spesso non è possibile scoprire perché un sistema di IA ha preso una decisione o una previsione e ha intrapreso una particolare azione. Pertanto, può diventare difficile valutare se qualcuno sia stato ingiustamente svantaggiato, ad esempio in una decisione di assunzione o in una domanda di un regime di pubblica utilità.

Sebbene la legislazione esistente offra una certa protezione, non è sufficiente per affrontare le sfide specifiche che i sistemi di IA possono comportare.

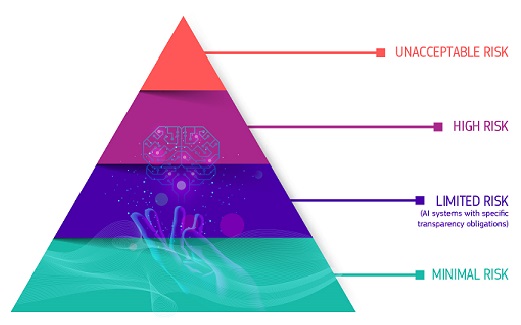

Un approccio basato sul rischio

La legge sull'IA definisce 4 livelli di rischio per i sistemi di IA:

Rischio inaccettabile

Tutti i sistemi di IA considerati una chiara minaccia per la sicurezza, i mezzi di sussistenza e i diritti delle persone sono vietati. La legge sull'IA vieta otto pratiche, vale a dire:

- manipolazione e inganno dannosi basati sull'IA

- sfruttamento dannoso delle vulnerabilità basato sull'IA

- punteggio sociale

- Valutazione o previsione del rischio di reato individuale

- raschiamento non mirato di materiale Internet o CCTV per creare o espandere banche dati di riconoscimento facciale

- riconoscimento delle emozioni nei luoghi di lavoro e negli istituti di istruzione

- categorizzazione biometrica per dedurre determinate caratteristiche protette

- identificazione biometrica remota in tempo reale a fini di contrasto in spazi accessibili al pubblico

Rischio elevato

I casi d'uso dell'IA che possono comportare gravi rischi per la salute, la sicurezza o i diritti fondamentali sono classificati come ad alto rischio. Questi casi d'uso ad alto rischio includono:

- Componenti di sicurezza dell'IA nelle infrastrutture critiche (ad esempio i trasporti), il cui guasto potrebbe mettere a rischio la vita e la salute dei cittadini

- Soluzioni di IA utilizzate negli istituti di istruzione, che possono determinare l'accesso all'istruzione e al corso della vita professionale di qualcuno (ad esempio punteggio degli esami)

- Componenti di sicurezza dei prodotti basati sull'IA (ad esempio applicazione dell'IA nella chirurgia assistita da robot)

- Strumenti di IA per l'occupazione, la gestione dei lavoratori e l'accesso al lavoro autonomo (ad esempio software di selezione dei CV per le assunzioni)

- Alcuni casi d'uso dell'IA utilizzati per dare accesso a servizi pubblici e privati essenziali (ad esempio, punteggio di credito che nega ai cittadini la possibilità di ottenere un prestito)

- Sistemi di IA utilizzati per l'identificazione biometrica remota, il riconoscimento delle emozioni e la categorizzazione biometrica (ad esempio il sistema di IA per identificare retroattivamente un taccheggiatore)

- Casi d'uso dell'IA nell'applicazione della legge che possono interferire con i diritti fondamentali delle persone (ad esempio valutazione dell'affidabilità delle prove)

- Casi d'uso dell'IA nella gestione della migrazione, dell'asilo e dei controlli alle frontiere (ad esempio esame automatizzato delle domande di visto)

- Soluzioni di IA utilizzate nell'amministrazione della giustizia e nei processi democratici (ad esempio soluzioni di IA per preparare le sentenze dei tribunali)

I sistemi di IA ad alto rischio sono soggetti a obblighi rigorosi prima di poter essere immessi sul mercato:

- adeguati sistemi di valutazione e attenuazione dei rischi

- elevata qualità delle serie di dati che alimentano il sistema per ridurre al minimo i rischi di esiti discriminatori

- registrazione delle attività per garantire la tracciabilità dei risultati

- documentazione dettagliata che fornisca tutte le informazioni necessarie sul sistema e sulla sua finalità per consentire alle autorità di valutarne la conformità

- informazioni chiare e adeguate al deployer

- adeguate misure di sorveglianza umana

- elevato livello di robustezza, sicurezza informatica e accuratezza

Rischio limitato

Si tratta dei rischi associati alla necessità di trasparenza in merito all'uso dell'IA. La legge sull'IA introduce obblighi specifici di divulgazione per garantire che gli esseri umani siano informati quando necessario per preservare la fiducia. Ad esempio, quando si utilizzano sistemi di IA come i chatbot, gli esseri umani dovrebbero essere consapevoli del fatto che interagiscono con una macchina in modo da poter prendere una decisione informata.

Inoltre, i fornitori di IA generativa devono garantire che i contenuti generati dall'IA siano identificabili. Inoltre, alcuni contenuti generati dall'IA dovrebbero essere etichettati in modo chiaro e visibile, vale a dire deep fake e testi pubblicati allo scopo di informare il pubblico su questioni di interesse pubblico.

Rischio minimo o nullo

La legge sull'IA non introduce norme per l'IA ritenute a rischio minimo o nullo. La stragrande maggioranza dei sistemi di IA attualmente utilizzati nell'UE rientra in questa categoria. Ciò include applicazioni come videogiochi abilitati all'intelligenza artificiale o filtri antispam.

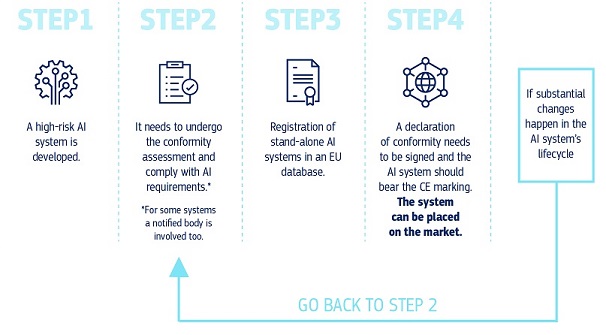

Come funziona nella pratica per i fornitori di sistemi di IA ad alto rischio?

Come funziona nella pratica per i fornitori di sistemi di IA ad alto rischio?

Una volta che un sistema di IA è sul mercato, le autorità sono responsabili della vigilanza del mercato, gli operatori garantiscono la sorveglianza e il monitoraggio umani e i fornitori dispongono di un sistema di monitoraggio post-commercializzazione. I fornitori e gli operatori segnaleranno anche incidenti gravi e malfunzionamenti.

Una soluzione per l'uso affidabile di modelli di IA di grandi dimensioni

I modelli di IA per finalità generali possono svolgere un'ampia gamma di compiti e stanno diventando la base di molti sistemi di IA nell'UE. Alcuni di questi modelli potrebbero comportare rischi sistemici se sono molto capaci o ampiamente utilizzati. Per garantire un'IA sicura e affidabile, la legge sull'IA stabilisce norme per i fornitori di tali modelli. Ciò include la trasparenza e le norme relative al diritto d'autore. Per i modelli che possono comportare rischi sistemici, i fornitori dovrebbero valutare e attenuare tali rischi.

Le norme della legge sull'IA sull'IA per finalità generali entreranno in vigore nell'agosto 2025. L'Ufficio per l'IA sta agevolando l'elaborazione di un codice di buone pratiche per precisare tali norme. Il codice dovrebbe rappresentare uno strumento centrale per i fornitori al fine di dimostrare la conformità alla legge sull'IA, integrando pratiche all'avanguardia.

Governance e attuazione

L'Ufficio europeo per l'IA e le autorità degli Stati membri sono responsabili dell'attuazione, della supervisione e dell'applicazione della legge sull'IA. Il comitato per l'IA, il gruppo di esperti scientifici e il forum consultivo guidano e consigliano la governance della legge sull'IA. Per saperne di più sulla governance e l'applicazione della legge sull'IA.

Prossime tappe

La legge sull'IA è entrata in vigore il 1o agosto 2024 e sarà pienamente applicabile due anni dopo, il 2 agosto 2026, con alcune eccezioni:

- divieti e obblighi di alfabetizzazione in materia di IA entrati in vigore il 2 febbraio 2025

- le norme di governance e gli obblighi per i modelli di IA per finalità generali diventano applicabili il 2 agosto 2025

- le norme per i sistemi di IA ad alto rischio - integrati in prodotti regolamentati - hanno un periodo di transizione prorogato fino al 2 agosto 2027

Ultime notizie

Politiche e legislazione

Scheda informativa / Infografica

Contenuti correlati

Quadro generale

Per ulteriori approfondimenti

-

L'Ufficio europeo per l'IA e le autorità nazionali di vigilanza del mercato sono responsabili dell...

-

La Commissione mira ad aumentare il numero di esperti di IA formando e attirando un maggior numero...